QCD Robots Manager – Edition du fichier robots.txt

Le module Prestashop QCD Robots Manager vous permet d’éditer très facilement le fichier robots.txt de votre boutique, sans avoir à passer par l’édition du fichier à la racine du site et l’upload par FTP. C’est un gain de temps évident, surtout lorsqu’on doit ajuster rapidement des règles de crawl (refonte, mise en préprod, nettoyage d’URLs inutiles, etc.).

Fonctionnalités principales :

- Édition du

robots.txtdepuis le back-office (gain de temps, plus besoin de FTP) - Gestion du multi-boutiques : possibilité d’adapter le

robots.txtselon la boutique / contexte multi-store.

| Dernière mise à jour | février 2026 |

| Compatibilité version Prestashop | 1.6.1 à 9.0 |

| Prix | Sur devis (inclus pour nos clients avec TMA) |

Screenshots

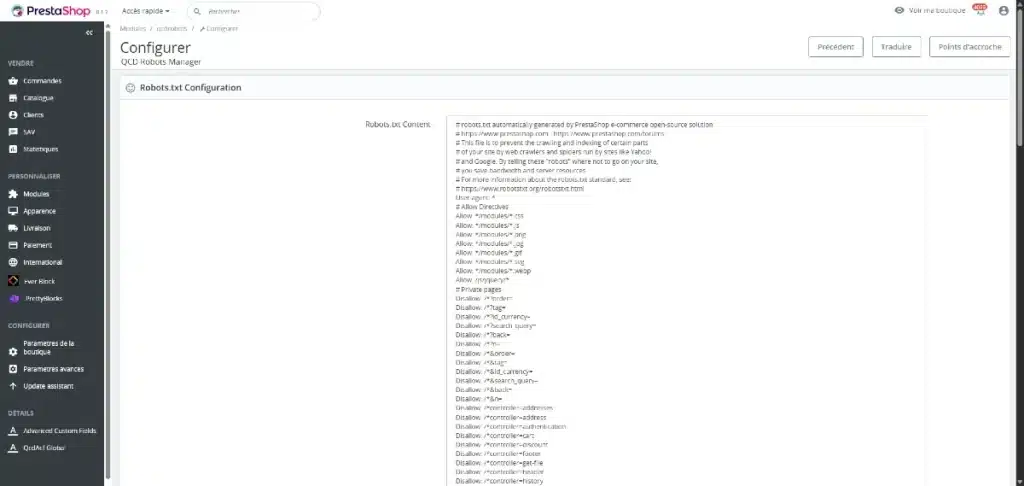

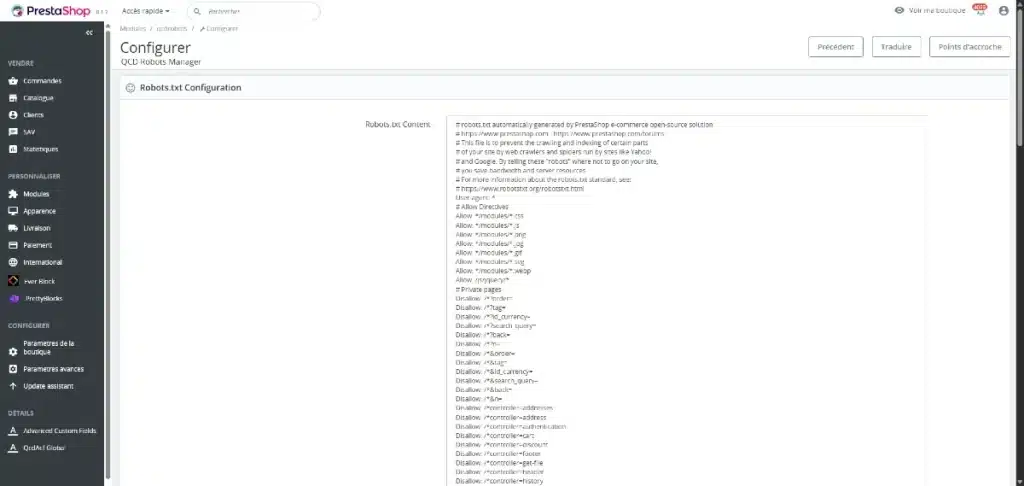

Edition du robots.txt depuis le back-office Prestashop

Description

A propos du fichier robots.txt

Le fichier robots.txt est un fichier texte placé à la racine de votre boutique. Il sert à donner des instructions aux robots des moteurs de recherche (Googlebot, Bingbot, etc.) sur les zones qu’ils peuvent explorer ou non.

Quelques rappels importants :

robots.txtn’empêche pas l’indexation à lui seul : il empêche surtout le crawl. Pour “désindexer”, on privilégie généralementnoindex(meta robots) ou des règles plus adaptées selon le cas.- Une mauvaise règle peut bloquer des ressources utiles (pages catégories, produits, fichiers CSS/JS), avec un impact SEO potentiel.

Le module est conçu par notre agence prestashop pour vous permettre de gérer ce fichier sans friction, au bon endroit : dans le BO Prestashop

Création, édition du fichier

- Rendez-vous dans le Back Office Prestashop

- Ouvrez la configuration du module QCD Robots Manager

- Vous accédez à un écran d’édition vous permettant de créer / modifier le contenu du

robots.txt - Enregistrez : le fichier est mis à jour immédiatement (et prêt à être lu par les robots)

Un screenshot illustre l’édition du fichier directement dans Prestashop.

Si votre Prestashop est en multi-boutiques, le module permet d’adapter la gestion du robots.txt à ce contexte (par exemple, règles différentes selon l’environnement ou la boutique).

Bonnes pratiques (SEO) : exemples de règles courantes

Voici quelques exemples typiques (à adapter à votre structure d’URLs et à votre stratégie) :

- Bloquer des pages peu utiles au SEO (ex. certaines pages de recherche interne, filtres, paramètres)

- Éviter le crawl de zones techniques (ex. pages panier/commande, endpoints spécifiques)

- Laisser accessibles les pages business (catégories, produits, CMS utiles)

⚠️ Attention : évitez de bloquer des pages qui génèrent du trafic organique, et évitez de bloquer des fichiers nécessaires au rendu (CSS/JS) si votre thème en dépend.