Chute de trafic SEO : méthode de diagnostic & solutions

Fidèle à vos habitudes, vous consultez les courbes Google Analytics et/ou Search Console du trafic SEO de votre site ou boutique en ligne, et c’est le drame ! Votre courbe de trafic organique est en chute libre et vous craignez le pire pour votre activité en ligne. Pas de panique ! Dans bien des cas, cette baisse n’est ni définitive, ni grave. Mais il se peut également que des erreurs soient les responsables de la chute SEO constatée. Pour adopter les bons réflexes, nous vous proposons une méthodologie pas à pas pour vous poser les bonnes questions et faire les correctifs nécessaires.

🧑💻Article rédigé par : David BARDY, Consultant SEO Senior

📆Publié le : 21 octobre 2025

Sommaire 📬

⌚Temps de lecture estimé : 10min

Comment reconnaître une vraie chute SEO ?

La vie d’un site Internet ou d’une boutique en ligne est un peu comme des montagnes russes : elle est faite de hauts et de bas ! Ce serait tellement beau que nos sites affichent des courbes de trafic organique à la croissance exponentielle, mais malheureusement, ce n’est absolument pas possible !

En tant que professionnels du référencement naturel, nous sommes souvent confrontés à des clients paniqués par des courbes qu’ils jugent anormales. Mais la première des questions à se poser est la suivante : est-ce réellement une vraie chute SEO ? En d’autres termes, cette baisse ne s’explique pas par des données connues.

Voyons ensemble une première distinction importante quand il s’agit d’analyser une chute SEO : la temporalité.

La visibilité organique ou les montagnes russes

Les résultats de recherche sur Google et tout autre moteur de recherche sont en perpétuels mouvements. Des nouvelles pages arrivent dans le top 100, d’autres sortent. Certaines gagnent des positions quand d’autres en perdent.

D’ailleurs, un système de classement des résultats dénommé “Transition Rank“ est même chargé de faire faire les montagnes russes à nos contenus. L’objectif : lutter contre les pratiques SEO abusives. Afin de limiter les actions visant à manipuler le classement des pages, Google va faire faire du “yoyo” à une page jusqu’à 90 jours, jusqu’à atteindre sa position optimale.

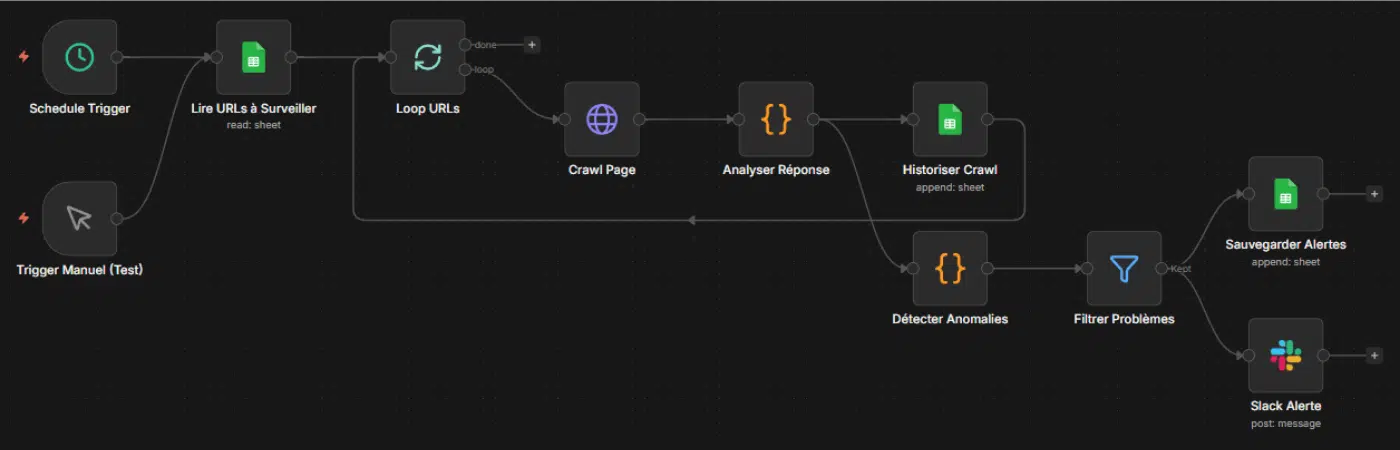

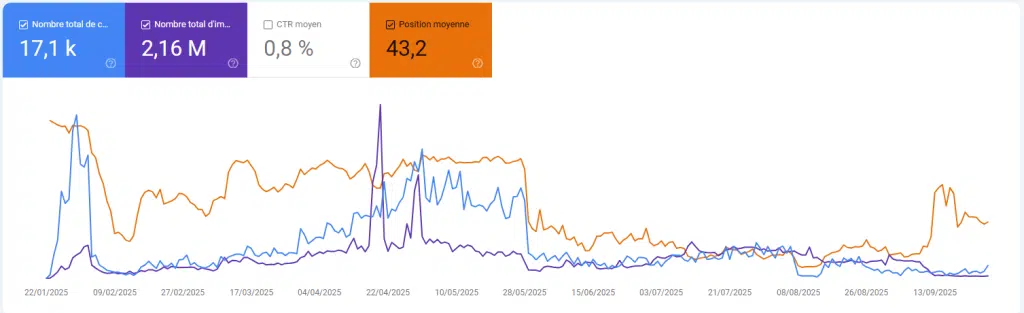

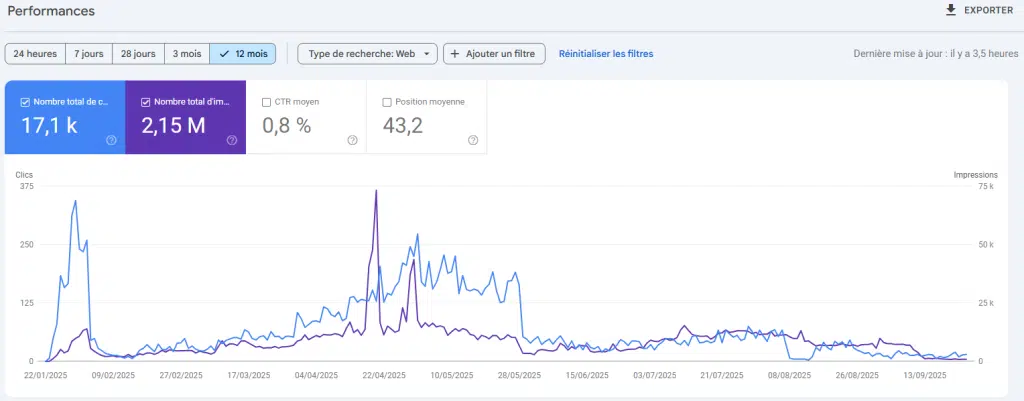

Prenons l’exemple du site ci-dessus. Ces statistiques sont celles d’une boutique en ligne spécialisée dans la vente de barbecues et autres accessoires pour cuisine d’extérieur.

Si on se focalise sur la flèche, nous pouvons constater une chute importante des clics, mais dans la même temps, une courbe de position moyenne en croissance. La conclusion : en regardant les dates, on comprend mieux que cette baisse est saisonnière ! En effet, passé l’été, les recherches sur les BBQ chutent logiquement, surtout avec l’arrivée de la rentrée.

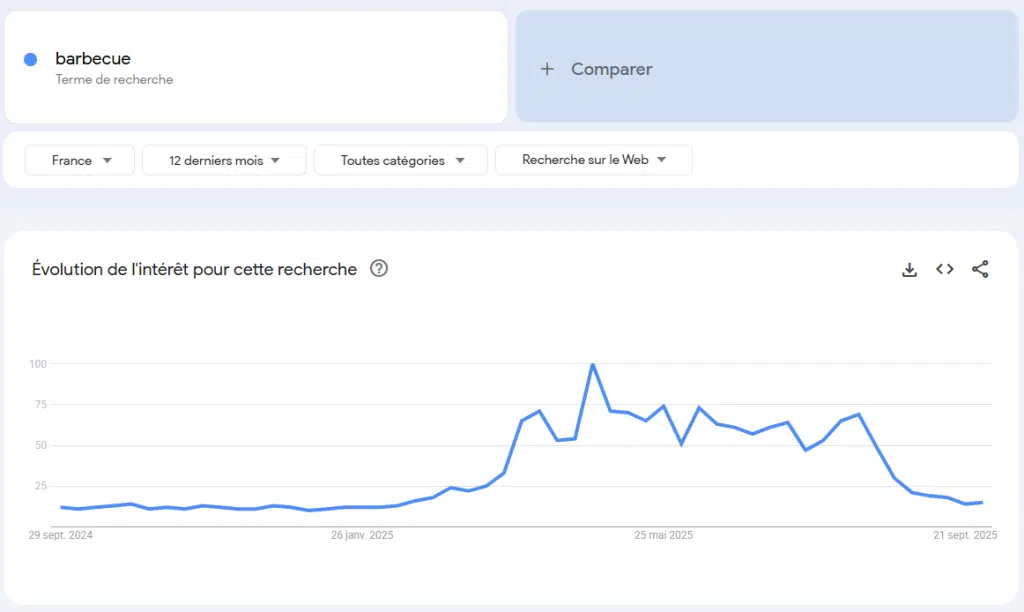

En cas de doute sur la saisonnalité d’une recherche, vous pouvez consulter l’outil Google Trends pour confirmer ou infirmer ce fléchissement dans la demande.

Assez logiquement, s’il y a moins de recherches sur les BBQ sur le moteur de recherche, il y aura à l’arrivée moins de clics ! Et ce n’est là qu’une des raisons exogènes qui peuvent expliquer une baisse des visites provenant des moteurs de recherche.

Une chute soudaine et brutale ou une érosion lente et progressive ?

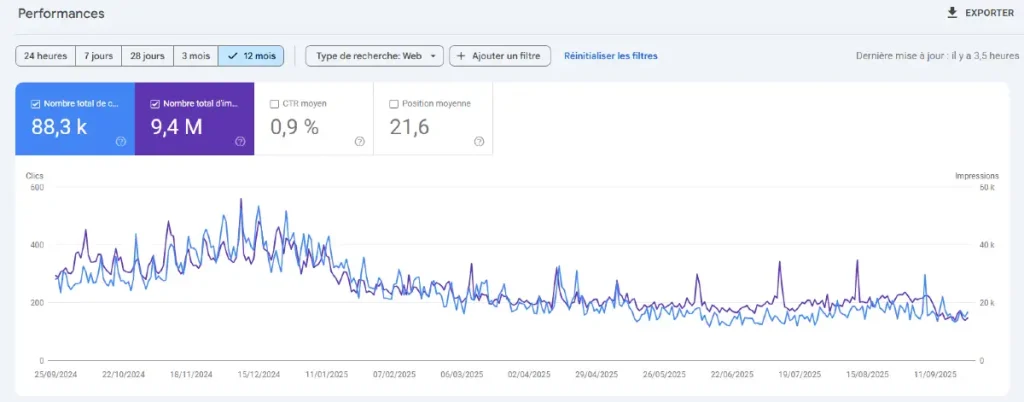

Les deux courbes ci-dessous sont issues de deux propriétés Google Search Console (GSC) différentes.

Sur la courbe du premier graphique, la chute abrupte et soudaine est bien visible. La courbe de l’image suivante en revanche est lente et graduelle.

Pour le premier cas, même si la chute semble anormale au premier abord, il est nécessaire de s’assurer que cette baisse l’est réellement. Cette baisse pourrait tout à fait s’expliquer par le calendrier ou tout autre évènement, comme la fin d’une période de soldes par exemple.

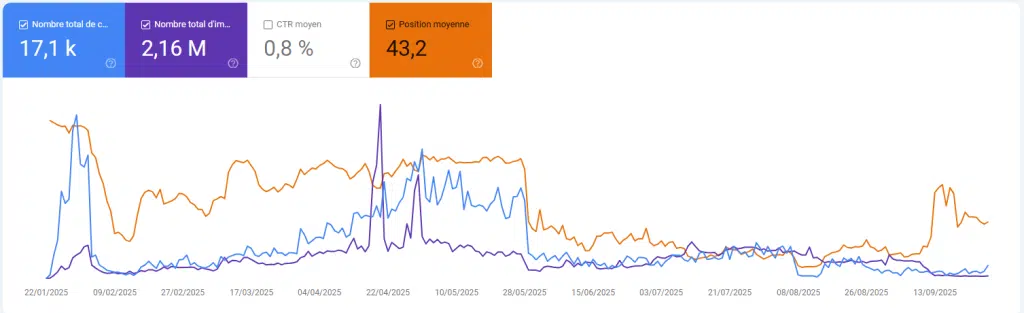

Le premier réflexe à adopter pour éclaircir les raisons de cette chute est de regarder l’évolution de la courbe des positions moyennes. Ci-dessous, la même courbe mais avec la superposition de la position moyenne.

Dans le cas présent, la chute brutale des positions, accompagnée d’une chute des clics, prouve clairement que le site a été impacté négativement par les algorithmes de classement.

À l’inverse, la courbe du bas (érosion lente) raconte une autre histoire. Elle ressemble moins à un “accident” qu’à une glissade progressive due à plusieurs petits facteurs qui s’additionnent : contenu qui vieillit, concurrence plus agressive, SERP qui se complexifient (extraits enrichis, vidéos, carrousels, comparateurs), cannibalisation interne, etc. On n’y traite pas une “panne” ; on rééquilibre un écosystème.

Aussi, pour vous aider à différencier le bruit normal d’une chute anormale, nous vous proposons un auto-diagnostic express !

Diagnostic express en 60 minutes (checklist pas à pas)

Etape 1 : vérifier les données (15 min)

La toute première chose à faire est de comparer les données provenant de votre outil de suivi d’audience (GA4 ou autre) avec les données de la GSC. Pour consolider davantage vos données, il est même recommandé de comparer les données provenant des logs serveurs.

Vérifiez par conséquent dans lequel des 3 cas suivants vous vous trouvez :

- Les courbes GA4 et GSC se superposent. Les données sont fiables et la chute est confirmée. Reportez au point 4 pour mesurer avec plus de précision l’ampleur de la baisse (mots clés, pages concernées).

- Les courbes différent mais seule la courbe GA4 chute : le problème peut provenir du marquage GA4 ou de l’intégration du Consent Mode V2. Dans ce cas, il est recommandé de passer en mode DebugView pour identifier le problème.

- Les courbes différent mais seule la courbe GSC chute : la console n’est pas exempte de bugs. Encore récemment, le trafic provenant de Google Discover remontait mal dans la GSC (cf. article Search Engine Land). Dans ce cas, une recherche sur le moteur et sur les réseaux sociaux peut confirmer la présence du bug pour d’autres éditeurs.

Etape 2 : écarter un bug/ erreur technique sur le site (15 min)

Une erreur technique peut impacter de manière importante votre référencement naturel ! Prenons le cas le plus courant d’erreur : l’oubli de la suppression des balises “noindex” lors de la mise en production d’un nouveau site.

La seconde chose à faire est donc de regarder du côté des interventions humaines sur le site. Quelqu’un a-t’il modifié quelque chose le ou les jours précédant la chute ? Une mise à jour du site a été effectuée peu de temps avant la baisse constatée ?

Robots.txt mal configuré, balise noindex, changement de structure d’URL : de nombreuses erreurs peuvent bloquer l’exploration et/ou l’indexation des pages d’un site Internet.

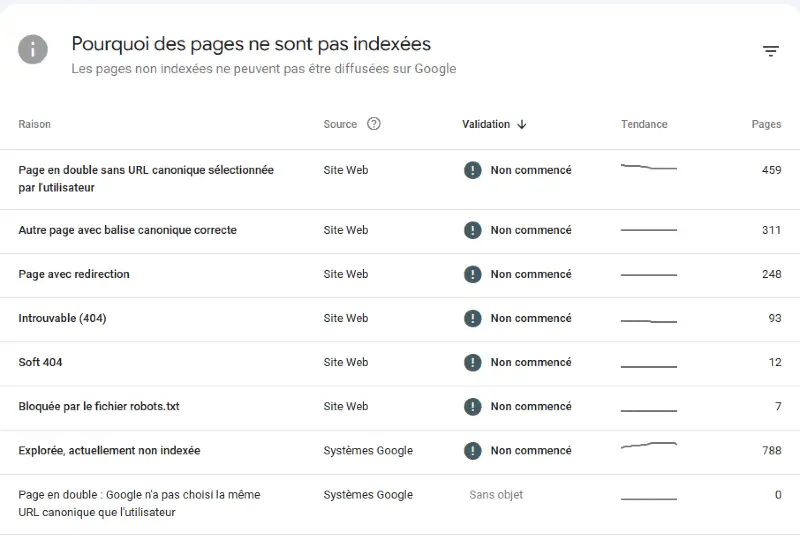

Pour écarter rapidement une erreur technique, consulter le rapport Indexation > Indexation des pages de votre propriété Search Console.

Dans le même temps, lancez un crawl de votre site à l’aide d’un outil tel que Screaming Frog SEO Spider Website Crawler.

Etape 3 : regarder du côté des mises à jour algorithmiques (15 min)

Vous venez d’ écarter un problème technique lors des deux premières étapes ? Il se peut alors que ce soient les règles qui aient changé !

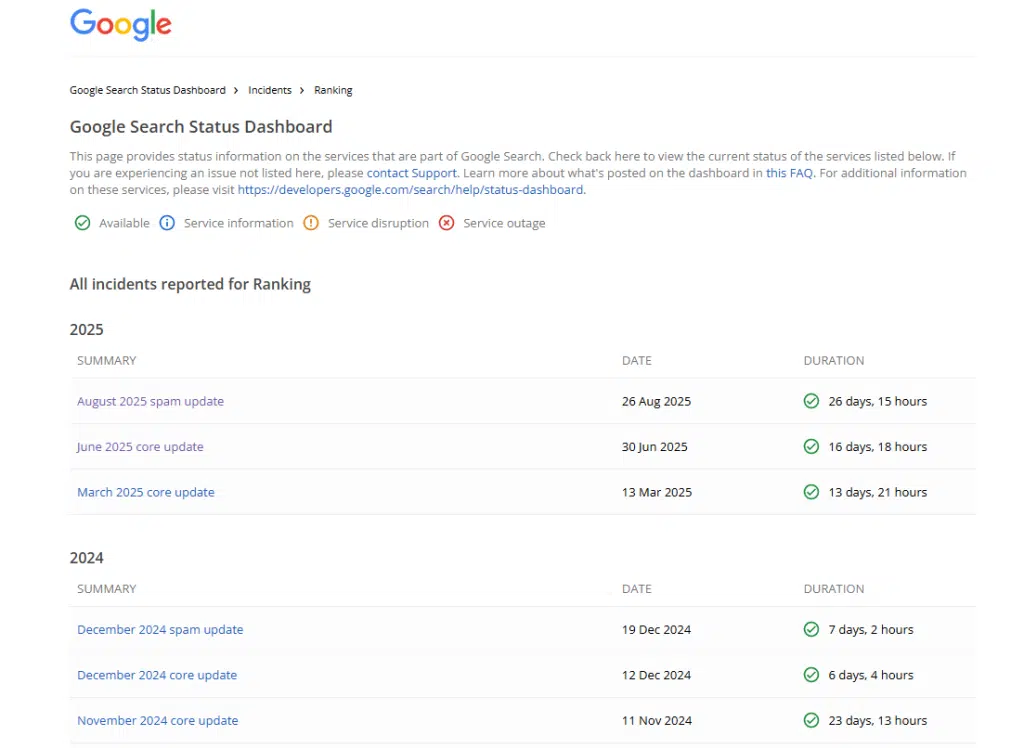

Il faut savoir qu’il modifie plusieurs fois par an ses algorithmes et systèmes de classement. Et parmi toutes les modifications apportées, les mises à jour majeures sont celles qui peuvent impacter le référencement naturel, de manière positive ou négative.

En 2024, 7 mises à jour majeures ont été déployées, dont certaines ont été parfois dévastatrices pour des éditeurs de site. Des mises à jour de deux types : les Core Update modifient le système de classement, les Spam Update luttent contre les pratiques abusives.

En règle générale, si vous constatez une chute importante des clics organiques et/ou des positions moyennes dans les 30 jours suivant une mise à jour, il faudra prévoir un plan d’action post-Core Update pour redresser l’audience.

Étape 4 : mesurer l’impact business (15 min)

Jusqu’à présent, nous n’avons analysé que les statistiques globales d’un site. Or, la baisse des visiteurs organiques ne touche pas forcément l’intégralité des pages d’un site et l’intégralité des types de recherche (images, web).

Le meilleur moyen de comprendre ce phénomène de baisse est d’appliquer des filtres sur le rapport de performance de la Search Console. Des filtres qui permettent d’identifier soit une tendance globale soit une tendance isolée (par type de page, pays…).

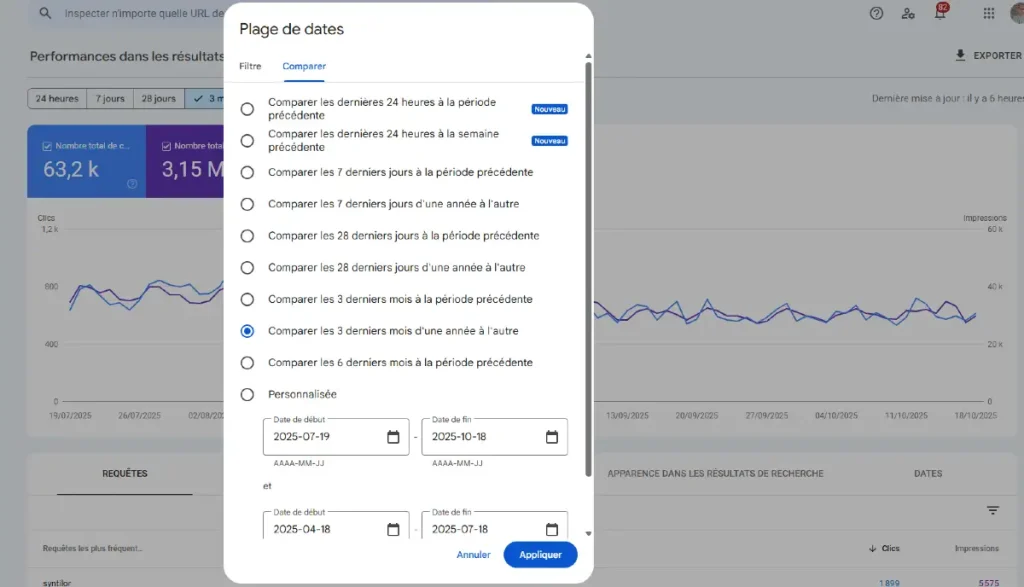

Rendez-vous donc dans le rapport “Performances” de la GSC puis sélectionnez deux plages de dates.

Vous pouvez par exemple comparer les deux mois qui ont précédé la mise à jour aux deux suivants. Ou tout simplement, comparer les 3 derniers mois à l’année passée.

Gardez surtout à l’esprit les caractéristiques de votre activité. Est-elle fortement impactée par la saisonnalité, des événements particuliers (ex : événements sportifs majeurs comme la Coupe du Monde par exemple). Le but est de pouvoir comparer deux périodes sensiblement identiques du point de vue de l’activité.

Autre point important, si votre site est multilingue, veillez à comparer les performances par pays. Il est tout à fait possible qu’une version du site ait plus souffert qu’une autre. Exemple : votre site en version anglaise pourrait avoir souffert du déploiement d’IA Overview au Royaume Uni !

Les grandes familles de causes… et comment les reconnaître

Les problèmes de mesure (pas une vraie chute SEO)

GA4 & Consent Mode v2

Comme l’indique le titre, on ne parle pas ici d’une baisse des clics organiques mais d’un problème de tracking.

Un problème qui peut survenir en raison d’un bug ou du changement du module de recueil du consentement.

En effet, un simple changement d’interface peut avoir des conséquences sur le taux de cookies refusés et in fine sur les statistiques d’audience.

🛠️ Les solutions : activez le mode DebugView de GA4 pour analyser les données qui remontent en temps réel. Vérifiez la bonne implémentation des scripts de tracking à l’aide de Tag Assistant.

Anomalies de données dans la GSC

Il arrive également que les données renvoyées par Google ne soient pas fiables. Comme vous pourrez le voir sur la page officielle de Google, c’est assez rare mais il ne faut pas l’exclure.

Le bug le plus fréquemment rencontré est celui du délai d’affichage des données dans la Search Console (voir tweet ci-après).

rho, ça cherche à faire des économies chez Google ?#GSC #searchconsole pic.twitter.com/0FDjjOkat4

— Raphael Doucet (@RaphSEO) February 8, 2025

🛠️ Les solutions : un petit tour sur X et les comptes officiels de Google permet dans la plupart des cas de vérifier si ces problèmes proviennent de la firme de Moutain View.

Les problèmes techniques on-site (indexation, erreurs serveurs, migrations)

Le robots.txt

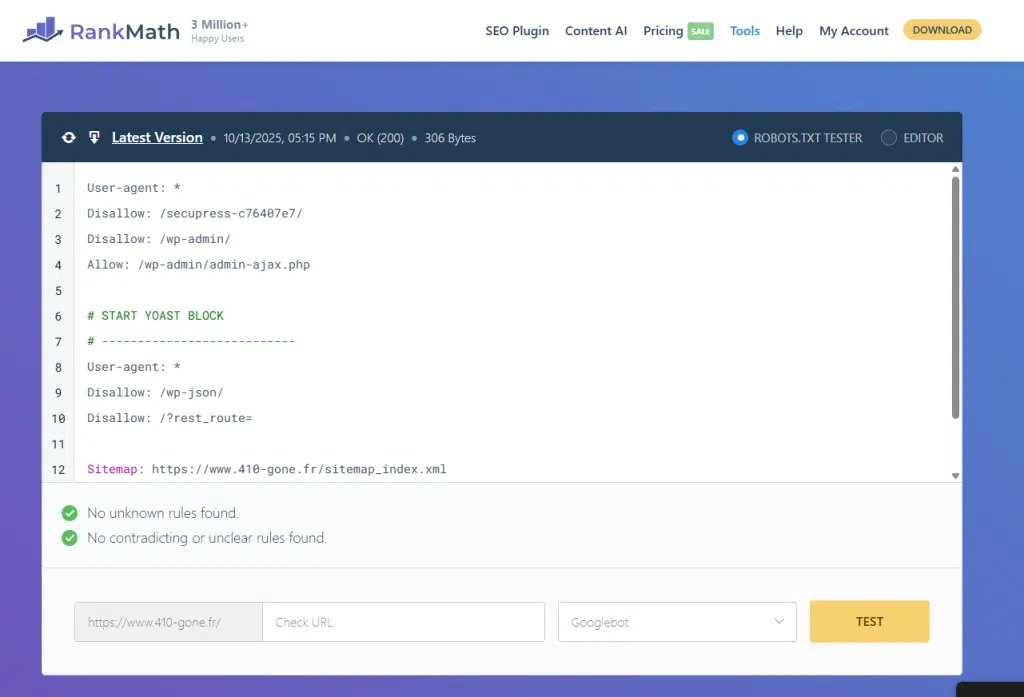

Même en 2025, il n’est pas rare de voir des erreurs de paramétrage du fichier robots.txt !

En bloquant l’accès aux robots d’exploration des moteurs de recherche à tout ou partie des fichiers d’un site, les conséquences peuvent être importantes sur son exploration, et indirectement, son trafic.

Voici les erreurs les plus courantes :

- Blocage accidentel de tout le site : si vous trouvez le code ci-dessous sur votre site, c’est forcément mauvais signe !

- Blocage des fichiers de ressources importants pour le chargement de pages (css, javascript, images).

- Mauvaise gestion des environnements de développement préprod / prod

- Mauvaise hiérarchisation des directives par user-agent

🛠️ Les solutions : à l’instar de l’outil de RankMath, il existe certains outils permettant de vérifier la présence d’erreurs ou règles contre-productives pour le SEO. Mais vous pouvez également demander à ChatGPT de vérifier la syntaxe ou d’optimiser votre fichier pour Google !

Meta et X-Robot Tag “Noindex”

Votre site vient d’être mis à jour ou refondu ? C’est souvent par là qu’il faut commencer à chercher ! Cette balise interdit tout simplement à Google d’indexer une page. Et sans indexation, pas de visiteurs !

La balise <meta> noindex est souvent utilisée (à tort) sur les environnements de pré production lors de la refonte d’un site Internet. Une fois le nouveau site mis en ligne, il n’est pas rare que les balises soient oubliées. Résultat : le site ne sera jamais indexé !

🛠️ Les solutions : consultez et analyser le rapport Indexation sur la Search Console. II vous indiquera si une ou plusieurs pages ne sont pas indexées en raison d’une balise “noindex”.

URL canoniques

Une URL canonique est une balise HTML (rel=”canonical”) qui indique à Google quelle version d’une page est la “principale” lorsque plusieurs URL affichent un contenu identique ou très similaire. Une mauvaise configuration peut entraîner des problèmes SEO sérieux.

Voici les erreurs les plus fréquentes :

- Canoniser une page vers une URL non-indexable

- Avoir plusieurs balises canoniques sur une même page

- La mauvaise canonicalisation : c’est le cas classique où une page A désigne une page B comme canonique, alors qu’elle devrait être sa propre référence.

- Canoniser une page paginée vers la première page : il s’agit d’une erreur très fréquente sur les blogs ou pages de catégories des sites e-commerce (Prestashop surtout).

🛠️ Les solutions : La GSC est votre meilleur allié, car elle vous montre exactement ce que Google comprend de vos URL canoniques. D’autres outils tels que Screaming Frog ou les outils d’audit de Ahrefs simulent le passage d’un robot d’exploration sur votre site et vous donnent une vision complète de toutes vos balises canoniques. C’est la meilleure méthode pour les audits de sites volumineux.

Migrations et changements d’URL

Dans plus de la moitié des cas après une migration, l’absence ou la mauvaise gestion des redirections (après un changement d’URL) est responsable de la chute de trafic SEO.

Dans le cas d’un changement de structure d’URL, et sans redirection, ni les internautes ni les moteurs de recherche ne peuvent savoir qu’une page a changé d’adresse.

🛠️ Les solutions : vérifiez qu’un plan de redirection a bien mis en place avant la refonte. Ce plan doit lister l’intégralité des URL de l’ancien site ainsi que les URL de redirection pour chacun d’entre-eux.

Les problèmes de qualité & spam

Si vous avez écarté les deux premiers coupables de votre diagnostic, il se pourrait bien que ce soit juste les règles du jeu qui aient changé. Et par règle il faut comprendre la mise à jour des algorithmes de Google.

Les Google Core Update

Comme leur nom l’indique, ces modifications concernent le cœur des systèmes de recherche du moteur. Leur impact peut être considérable, aussi bien de manière positive que négative sur la visibilité d’un site au sein du moteur de recherche.

Pour simplifier, ces mises à jour ciblent la qualité des résultats de recherche et de facto, des contenus indexés. Voici ce que dit la documentation officielle du géant américain sur le fonctionnement de ces mises à jour :

“L’objectif de ces mises à jour est de fournir aux internautes des résultats toujours plus utiles et fiables. Ces modifications sont par nature générale et ne ciblent pas de sites ni de pages Web spécifiques. À mesure que le contenu sur le Web évolue, nous évaluons et mettons à jour nos systèmes pour suivre le rythme.”

D’après la firme de Moutain View, toute baisse constatée après une Core Update n’est pas une pénalité mais davantage un déclassement au profit de pages ou sites plus utiles et plus pertinents pour les utilisateurs. A propos de contenu utile, il faut retenir que les signaux “Google Helpful Content” suivants sont désormais intégrés aux Core Update.

- Favorise les contenus rédigés pour des humains et non pour les moteurs

- Privilégie les pages qui apportent une valeur ajoutée, des informations supplémentaires par rapport aux contenus existants

- Pénalise les contenus sans valeur publiés en grande quantité et/ou de manière automatisée

Malheureusement, dans le cas d’une Core Update ayant eu un impact négatif, il est très difficile d’identifier un critère isolé ayant impacté votre classement. Seul un audit SEO approfondi peut permettre de mettre en lumière des problèmes de qualité à l’échelle du site entier. En outre, il est dit qu’aucune action corrective rapide n’est possible pour redresser votre trafic organique. Seule une stratégie éditoriale qualitative à moyen/ long terme peut vous permettre de corriger le tir.

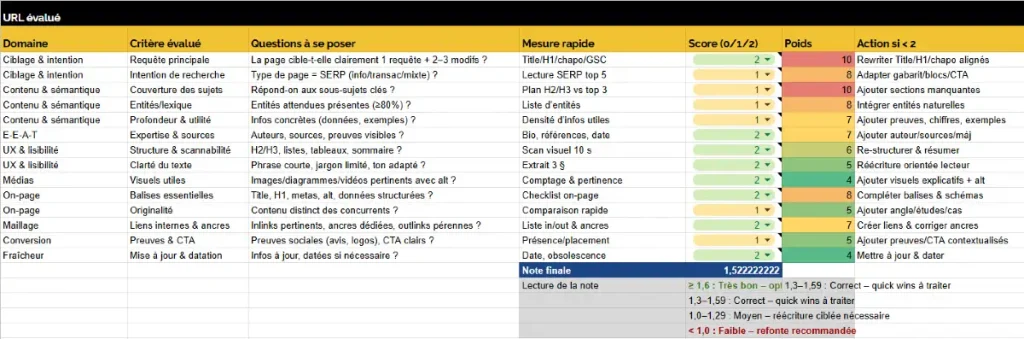

Et pour votre stratégie, Google vous invite à auto-évaluer votre contenu autour du prisme de l’EEAT. L’objectif : vous aider à comprendre pourquoi votre contenu est moins bon que les autres. Au sein de notre agence SEO, nous avons crée une métholodogie d’évaluation basée sur les critères suggérés par Google dans sa documentation officielle :

🛠️ Les solutions : si vous privilégiez toujours la qualité à la quantité, l’internaute face aux moteurs, vous devriez dans la plupart des cas passer au travers des mailles des Core Update.

Les Google Spam Update

Les Spam Update visent tous les sites Internet qui enfreignent les règles concernant le spam.

Keyword stuffing, production de contenus de très mauvaise qualité à grande échelle, liens toxiques : si vous constatez une corrélation entre la chute et le déploiement d’une spam update, c’est que vous avez été rattrapé par la patrouille !

Toutes les pratiques visant à manipuler les algorithmes de classement sont ciblées par les Spam Update. Crée en 2021, l’algorithme SpamBrain a réussi à “identifier 200 fois plus de site contenant du spam qu’en 2000 lors des débuts de Google“. (cf SpamBrain report). Le Spam concerne donc aussi bien le contenu interne d’un site que les liens qui pointent vers lui.

En ce qui concerne les liens toxiques / factices / achetés, si ces derniers sont identifiés par les algorithmes, le bénéfice qu’ils apportaient sera tout simplement annulé. Et donc, rien ne pourra permettre de compenser les pertes subies au classement.

Pour le contenu en revanche, des actions correctives pourront permettre au site, lors de la prochaine update, de relancer son trafic organique.

🛠️ Les solutions : Google sait assez facilement dissocier les sites “spammy” des sites qualitatifs. Si certaines de ces techniques sont efficaces pour gagner du trafic à court terme, elles le sont rarement à long terme.

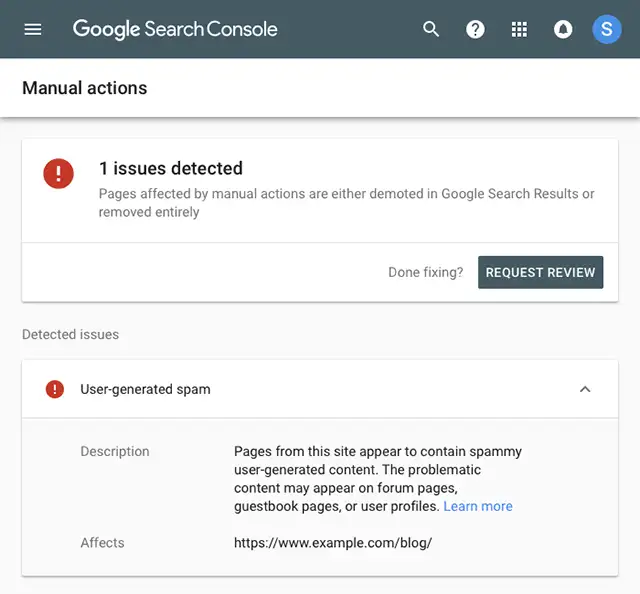

Les pénalités manuelles

Lorsque des évaluateurs humains, les fameux “Google Quality Raters”, constatent qu’un site ne respecte pas les règles concernant le spam, les informations remontées par ces derniers peuvent conduire à une pénalité manuelle après examen.

Cette action manuelle peut résulter en la disparition de tout ou partie du contenu du site des résultats de recherche. Pour savoir si un site a fait l’object d’une action manuelle, il suffit de se rendre dans la Google Search Console du domaine > Sécurité et actions Manuelles > Actions manuelles.

Si tout va bien, le message “Aucun problème détecté” apparaît. A l’inverse, en cas de problème, le type de message suivant peut apparaître.

Soyons honnête : ce type de message est plutôt rare et rarement bon signe pour votre référencement naturel. Cette section vous invite toutefois à corriger le problème identifié, puis à contacter le support du moteur pour lui signifier la correction apportée.

Les problèmes d’intention & UX

Le changement d’intention de recherche

La visibilité organique ne dépend pas seulement de ton contenu et de ton site : elle évolue aussi en fonction de ce que Google affiche sur la page de résultats et de la manière dont les utilisateurs formulent leurs recherches. Une baisse de clics peut donc survenir sans perte de position apparente. Comprendre ces dynamiques est essentiel pour ajuster ta stratégie et conserver tes parts de visibilité.

Voici une citation et chiffre officiels pour vous aider à quel point les recherches effectuées par les utilisateurs sont en constante évolution :

S’il est une chose que j’ai apprise au cours des 15 années passées à travailler sur Google Search, c’est que la curiosité des gens est sans fin. Des milliards de recherches sont effectuées chaque jour, et 15 % d’entre elles sont des requêtes que nous n’avons jamais vues auparavant. Pandu Nayak – Google fellow and vice president Search

Et non seulement les requêtes évoluent en permanence, mais les contenus concurrents aussi ! Le SEO est une course permanente, sans ligne d’arrivée, dans laquelle 100 contenus se disputent les 10 premiers résultats de recherche pour obtenir un maximum de visibilité.

De même, le moteur affine en permanence sa compréhension des intentions derrière chaque requête. Une requête autrefois perçue comme informationnelle (“meilleur parquet pour salon”) peut devenir transactionnelle (“acheter parquet chêne massif”) ou comparative (“parquet chêne vs stratifié”). Résultat : les contenus purement informatifs perdent du terrain au profit de pages e-commerce, guides d’achat ou comparateurs.

Si une ou plusieurs pages ont perdu des positions sur la SERP, un benchmark des contenus concurrents s’impose ! Voici les bons réflexes à adopter pour vous assurer que votre contenu est toujours aligné à l’intention de recherche :

- Surveiller l’évolution de la SERP réelle (via des captures des résultats ou des outils comme Ahrefs et SEObserver)

- Identifier les éléments enrichis qui apparaissent sur tes requêtes clés

- Identifier les nouveaux entrants dans la SERP (domaines et types de contenus)

- Comparer leurs formats, balises structurées, profondeur de contenu, médias intégrés.

Mauvais signaux d’expérience utilsateur

L’ère du SEO purement technique ou “mots-clés + backlinks” est bel et bien révolue. Les fuites d’archives internes l’ont confirmé : l’expérience utilisateur (UX), entendue comme « tout ce que l’internaute vit après avoir cliqué sur votre résultat ou navigué sur votre site », est désormais intégrée, à divers degrés, dans les systèmes de classement.

Les documents internes divulgués au travers des “Google Leaks” mentionnent explicitement des modules internes comme NavBoost (parfois nommé aussi “Glue”), qui exploitent des données de comportement utilisateur, provenant entre autres du navigateur Google Chrome, pour ajuster les résultats de recherche.

Ce que cela signifie pour vous : si vos utilisateurs cliquent sur votre site dans la SERP mais repartent très vite une fois arrivés sur la page, ou s’ils rencontrent des frictions (ex. lenteur, navigation difficile, contenu peu clair), cela peut être interprété comme un mauvais signal UX, et donc un risque pour votre positionnement organique.

Voici les principaux leviers UX à prendre en compte pour aligner votre site avec ce que les algorithmes semblent privilégier :

| Signal UX | Pourquoi c’est important | Comment l’optimiser |

|---|---|---|

| Temps de chargement & First Input Delay (FID) | Une page lente ou peu réactive entraine impatience/utilisateur partant vite → mauvais signal. | Hébergement performant, réduction JS bloquant, chargement asynchrone, optimisation mobile. |

| Largest Contentful Paint (LCP) & Cumulative Layout Shift (CLS) | Google a intégré ces métriques dans les “Core Web Vitals” : stabilité visuelle + affichage rapide du contenu essentiel. | Pré-allocation hauteur d’images, éviter pop-ups intrusifs, prioriser le contenu above-the-fold. |

| Compatibilité mobile / Mobile-first | La majorité des requêtes sont mobiles, et Google indexe d’abord la version mobile. UX mobile mauvaise = signal négatif. | Design responsive, boutons/taps bien espacés, navigation claire sur mobile. |

| Parcours et navigation fluide | Si l’utilisateur ne trouve pas vite ce qu’il cherche, il repart. Le module interne NavBoost semble prendre en compte les “bons clics”. | Maillage interne soigné, menus clairs, chemin utilisateur logique, éviter les “cul-de-sac”. |

| Engagement utilisateur / Dwell time | Le fait que l’utilisateur “reste” signifie que le contenu répond à son besoin. Une sortie rapide = signal faible. | Rédiger pour répondre rapidement à l’intention, structurer les articles, inciter à explorer d’autres sections. |

| Taux de rebond / pogosticking | Un rebond rapide ou un retour à la SERP peut indiquer un mauvais alignement avec l’intention ou une UX frustrante. cf “Comment mesurer le taux de rebond de son site web ?“ | Adapter le titre/description : correspondre à l’intention, proposer CTA clairs, utiliser des visuels et des sous-titres pour capter l’attention. |

| Interactions utilisateur (scroll, clics, temps passé) | Ces signaux sont de plus en plus pris en compte comme indicateurs d’expérience de qualité. | Ajouter des ancres, sommaires, contenus visuellement engageants, incitations à passer à l’action. |

Références

- Déboguer les baisses du trafic de la recherche Google – https://developers.google.com/search/docs/monitor-debug/debugging-search-traffic-drops?hl=fr

- How to analyse a sudden drop in website traffic – Ahrefs – https://ahrefs.com/blog/analyze-sudden-traffic-drop/

- 3 underutilized GSC reports for diagnosing traffic drops – SearchEngineLand – https://searchengineland.com/google-search-console-reports-diagnosing-traffic-drops-438434

David BARDY

En près de 15 ans d’expérience en SEO, j’ai traversé bon nombres d’update et secousses en tous genres. Par chance et surtout par goût pour le content User-centric, j’ai (presque) toujours été épargné par les grosses baisses de trafic. Dans cet article, je vous partage mes astuces pour adopter les bons réflexes avant, pendant et après une chute SEO.