Le crawl budget

Pourquoi analyser ses logs ?

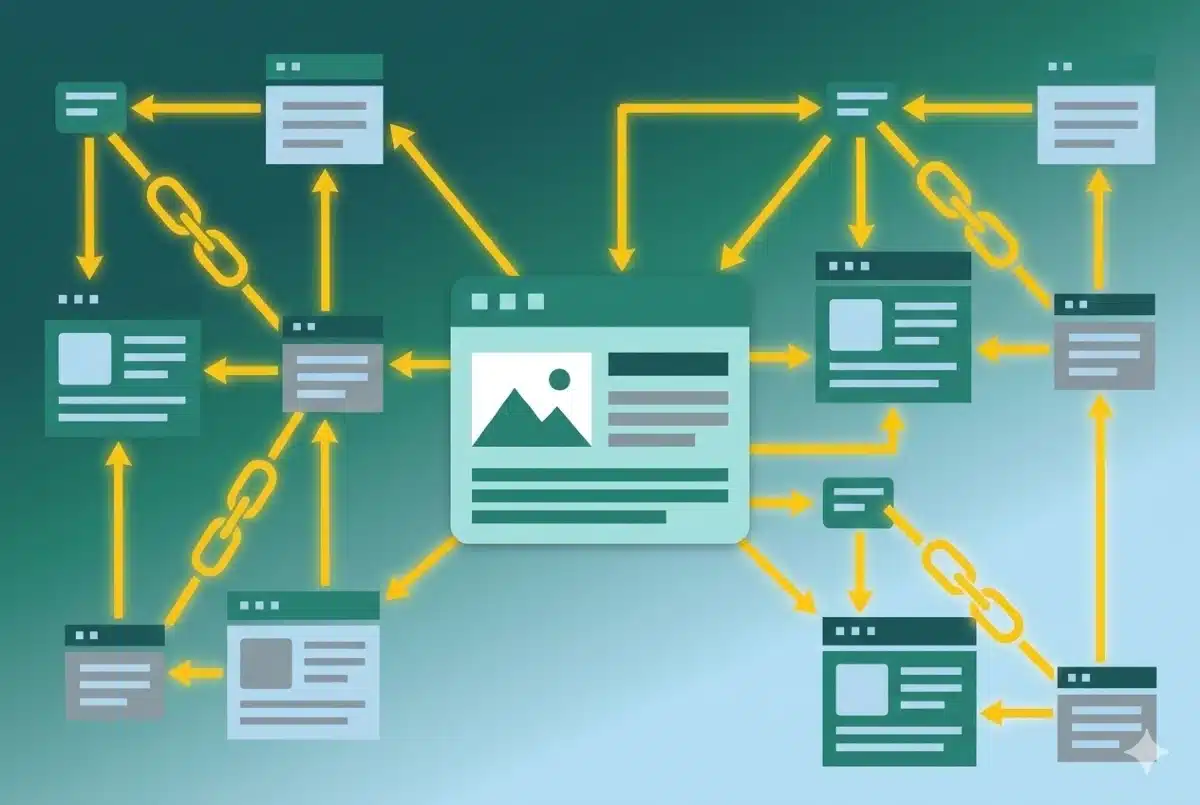

Commençons par définir ce qu’est le crawl budget : C’est le temps de parcours et d’analyse de votre site que google s’autorise quotidiennement. On peut faire un calcul simple: crawl budget/temps de chargement moyen de vos pages = nombres de pages visitées quotidiennement. Bien entendu, plus google crawl votre site fréquemment, plus il découvrira de nouvelles pages vite, plus votre référencement s’améliorera ! L’analyse de logs apache est donc une arme très puissante de l’optimisation on site de votre SEO.

Réduire le temps de chargement

On l’a dit, le nombre de pages analysées par Google bot (et les autres) dépend en partie du temps de chargement. On va donc avoir pour objectif de réduire celui-ci au maximum. Pour cela, des outils d’analyses comme la Search Console ou même GTmetrix peuvent vous aider. Récemment, l’outil audit dans Chrome permet une analyse très fine des raisons pour lesquelles votre page ne se charge pas suffisamment vite. Quoi qu’il en soit, plus vous baissez le temps de chargement, plus le nombre de page analysées quotidiennement augmentera. On observe d’ailleurs une corrélation à ce sujet dans la Search Console dans la section “statistiques sur l’exploration”. A noter que Google crawle toujours en http 1 et pas encore en http2 : il faut donc continuer de merger CSS et JS.

Limiter le nombre de requêtes

Une fois que toutes nos pages se chargent (pour la partie HTML) en moins de 250ms (on y croit, vous allez y arriver, un peu de cache Varnish de Nginx et c’est réglé !), on va passer à l’étape 2 : choisir quelles pages Google va parcourir. Là, on rentre dans la partie la plus technique de cette analyse car on va aller au delà du simple rel=nofollow. On va essayer de réduire le nombre de requêtes faites par Google. Objectif: retirer le crawl des facettes, des feeds x ou y, des images du thèmes etc… On utilisera pour ces dernières un sprite en CSS, une technique qui consiste à mettre tous les pictogrammes dans un même fichier jpg ou png puis, grâce aux CSS, définir quelle zone du fichier on appelle. On peut également mettre des pictogrammes dans un fichier de police d’écriture.

Comment récupérer ses logs google bot ?

Il est assez simple de trouver vos logs à analyser. Il faut simplement aller glisser ces quelques lignes dans votre virtual host apache et reload la configuration du serveur. Vous aurez un fichier log qui va commencer à se remplir avec le bon format de données pour Screaming Frog Log Analysis.

Cette configuration spécifique permet d’isoler dans un dossier et des fichiers dédiés uniquement les requêtes faites par des bots seo, ce qui facilitera leur sauvegarde en vue d’export pour analyse dans un outil tiers.

Screaming Frog Log Analysis

Les autres outils d’analyse de logs

Oncrawl

Oncrawl propose différentes solutions y compris sans engagement en fonction du nombres de lignes à analyser. Les prix vont des 9.90? mensuel à 250? et plus si besoin. On est donc sur un tarif assez faible pour débuter. L’avantage de oncrawl c’est qu’on a beaucoup de graphiques et que l’analyse de vos pages est très visuelle et moins technique, si vous devez faire du reporting à des équipes métiers, c’est appréciable. Il vous faudra cependant pousser les logs régulièrement vers leur ftp mais cela s’automatise assez facilement avec un cron jenkins ou autre. Plus d’informations sur : http://fr.oncrawl.com

Watussi box

La watussi box est un produit d’analyse de logs gratuit, je n’ai malheureusement pas eu le temps de le tester, je vous invite à le faire si vous le souhaitez et n’hésitez pas à me faire vos retours. plus d’informations sur : http://box.watussi.fr/

Botify

J’ai eu la chance d’assister à une démo de l’outil d’analyse de logs de botify en 2017, et je dois reconnaitre que l’outil est également très complet. Les tarifs sont plus élevés que sur oncrawl mais de ce que j’ai pu en voir, les possibilités sont énormes et les graphiques produits sont super qualitatifs. La partie pages orphelines ressort particulièrement bien pour une analyse très visuelle. Bravo ! Plus d’informations sur : https://www.botify.com/

Le trafic de notre client multiplié par 5 en 1 an grâce à une stratégie SEO personnalisée.

Conclusion ?

Que vous souhaitiez faire une analyse ponctuelle et une maintenance dans la durée, il existe des outils d’analyse à tous les tarifs. N’hésitez donc pas à passer à l’analyse de logs votre site pour en tirer le maximum de “seo juice” et doper votre visibilité sur internet ! Si cet article vous a plus, vous pouvez découvrir notre formation complète d’une journée à l’analyse de logs. Si vous souhaitez en savoir plus sur l’importance du maillage interne, consulter notre article sur la détection des pages orphelines en SEO.