5 workflows n8n + ChatGPT pour automatiser votre SEO

Générer des méta-descriptions, réécrire des fiches produits, catégoriser des mots-clés… Ces tâches SEO sont essentielles, mais chronophages. Bonne nouvelle : avec n8n et l’intelligence artificielle, vous pouvez les automatiser.

Dans cet article, on vous montre 5 workflows concrets qu’on utilise en agence SEO pour gagner du temps sur les tâches répétitives. Pas besoin d’être développeur : chaque workflow est accessible si vous avez des bases sur n8n.

🧑💻Article rédigé par : Charly ROUGET

📆Publié le : 09 janvier 2026

⌚Temps de lecture estimé : 11 min

Prérequis avant de commencer

Avant de lancer ces workflows, assurez-vous d’avoir :

- Un compte n8n (self-hosted ou cloud) avec une connexion à l’API OpenAI

- Une clé API OpenAI avec des crédits suffisants – les workflows utilisent GPT-4o ou GPT-4o-mini selon la complexité

- Vos sources de données : Google Search Console, Screaming Frog, Semrush, ou un simple fichier CSV

- Un endroit pour stocker les résultats : Google Sheets, Notion, Airtable, ou directement votre CMS (WordPress, Prestashop, Magento)

| Outil | Usage dans les workflows |

|---|---|

| n8n | Orchestration et automatisation des tâches |

| OpenAI (GPT-4o) | Génération et optimisation de contenu |

| Google Sheets | Import/export des données |

| Google Search Console | Récupération des requêtes et performances |

Niveau requis : vous devez savoir créer un workflow basique sur n8n (déclencher, connecter des nœuds, mapper des champs).

Si ce n’est pas le cas, commencez par la documentation officielle de n8n.

Workflow 1 – Générer des méta-descriptions en masse

Le problème qu’on résout

Vous avez 200 fiches produits sans méta-description. Ou pire : des méta-descriptions génériques copiées-collées partout. Résultat : un CTR faible dans les résultats Google et du contenu dupliqué qui plombe votre référencement.

Rédiger chaque méta à la main ? Comptez 2 à 3 minutes par fiche. Sur 200 produits, ça fait 10 heures de travail. Ce workflow ramène ça à quelques minutes.

Ce que fait ce workflow

- Il récupère une liste d’URLs avec leurs titres et descriptions produits (depuis un CSV ou Google Sheets)

- Il envoie chaque produit à ChatGPT avec un prompt optimisé

- Il génère une méta-description unique, avec mot-clé et call-to-action

- Il exporte le tout dans un fichier prêt à importer

Les nodes utilisés

| Node | Rôle |

|---|---|

| Google Sheets (ou CSV Read) | Importe la liste des produits à traiter |

| Loop Over Items | Traite chaque produit un par un |

| OpenAI (GPT-5.2) | Génère la méta-description |

| Google Sheets (ou CSV Write) | Exporte les résultats avec l’URL + la nouvelle méta |

Le prompt ChatGPT qu’on utilise

Tu es un expert SEO spécialisé en e-commerce.

Génère une méta-description pour ce produit :

- Nom du produit : {{nom_produit}}

- Description : {{description_produit}}

- Mot-clé principal : {{mot_cle}}

Contraintes :

- Maximum 155 caractères

- Inclure le mot-clé naturellement

- Terminer par un appel à l'action (découvrez, profitez, commandez...)

- Ton : professionnel mais engageant

Réponds uniquement avec la méta-description, sans explication.

Astuce : ajoutez une colonne “mot-clé principal” dans votre fichier source. La qualité du résultat dépend directement de cette donnée.

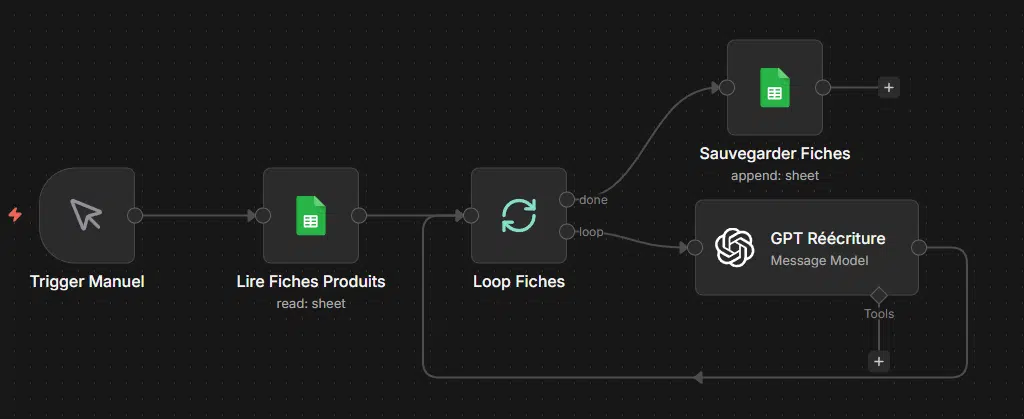

Workflow 2 – Réécrire les fiches produits dupliquées

Le problème qu’on résout

Votre fournisseur vous envoie des descriptions produits. Comme 50 autres e-commerçants. Résultat : Google voit du contenu dupliqué partout et ne sait pas qui indexer en priorité. Spoiler : ce n’est probablement pas vous.

Réécrire chaque fiche à la main pour la rendre unique ? Sur un catalogue de 500 produits, c’est un projet à plusieurs semaines. Ce workflow automatise la réécriture tout en gardant les informations techniques essentielles.

Ce que fait ce workflow

- Il importe vos fiches produits existantes (titre, description, caractéristiques)

- Il envoie chaque fiche à GPT-5.2 avec des consignes de réécriture SEO

- Il génère une version unique qui conserve les specs techniques mais reformule le reste

- Il exporte les nouvelles descriptions prêtes à intégrer

Les nodes utilisés

| Node | Rôle |

|---|---|

| Google Sheets (ou Airtable) | Source des fiches produits à réécrire |

| Loop Over Items | Traite chaque fiche individuellement |

| OpenAI (GPT-5.2) | Réécrit la description de manière unique |

| Google Sheets | Stocke les nouvelles versions |

Le prompt ChatGPT qu’on utilise

Tu es un rédacteur e-commerce expert en SEO.

Réécris cette fiche produit pour la rendre unique :

- Titre : {{titre_produit}}

- Description actuelle : {{description_actuelle}}

- Caractéristiques techniques : {{specs}}

- Mot-clé principal : {{mot_cle}}

Contraintes :

- Garder TOUTES les informations techniques (dimensions, matériaux, compatibilités...)

- Reformuler complètement le texte marketing

- Intégrer le mot-clé naturellement (2-3 occurrences max)

- Longueur : entre 150 et 300 mots

- Ton : informatif et orienté bénéfices client

Réponds uniquement avec la nouvelle description.

Point d’attention : vérifiez toujours les specs techniques après génération. L’intelligence artificielle peut parfois reformuler un “500W” en “puissance élevée”. Ce n’est pas ce qu’on veut.

Workflow 3 – Détecter les opportunités de maillage interne

Le problème qu’on résout

Votre blog e-commerce compte 150 articles. Votre catalogue, 800 produits. Entre les deux ? Probablement une dizaine de liens internes posés au hasard, quand vous y avez pensé.

Le maillage interne, c’est ce qui permet à Google de comprendre la structure de votre site et de distribuer le “jus SEO” vers vos pages stratégiques. Un mauvais maillage = des pages orphelines que personne ne trouve.

Analyser manuellement chaque page pour trouver les opportunités de liens ? Irréaliste. Ce workflow le fait pour vous.

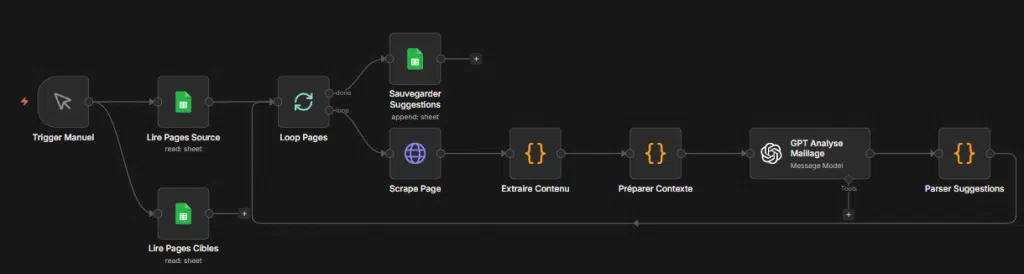

Ce que fait ce workflow

- Il récupère la liste de vos pages (articles de blog, catégories, fiches produits)

- Il analyse le contenu de chaque page pour extraire les thématiques principales

- Il croise ces données pour identifier les correspondances sémantiques

- Il génère une liste de suggestions : “Sur la page X, ajoutez un lien vers la page Y”

Les nodes utilisés

| Node | Rôle |

|---|---|

| Google Sheets | Liste des URLs à analyser avec leurs titres et mots-clés |

| HTTP Request | Récupère le contenu texte de chaque page |

| OpenAI (GPT-5.2) | Analyse le contenu et identifie les correspondances |

| Google Sheets | Exporte les suggestions de maillage |

Le prompt ChatGPT qu’on utilise

Tu es un expert SEO spécialisé en maillage interne.

Voici une page source :

- URL : {{url_source}}

- Titre : {{titre_source}}

- Contenu : {{contenu_source}}

Voici une liste de pages cibles potentielles :

{{liste_pages_cibles}}

Pour chaque page cible pertinente, indique :

1. L'URL cible

2. L'ancre de lien suggérée (texte cliquable)

3. L'endroit dans le contenu source où insérer le lien (cite la phrase)

4. Score de pertinence (1 à 10)

Contraintes :

- Ne suggère que des liens réellement pertinents (score minimum 7/10)

- L'ancre doit être naturelle, pas sur-optimisée

- Maximum 5 suggestions par page source

Réponds en JSON.

Pourquoi le format JSON ? Parce qu’on peut ensuite automatiser l’intégration des liens via l’API WordPress ou un autre outil. Le workflow devient un vrai agent qui travaille en autonomie.

Aller plus loin : automatiser l’insertion des liens

Ce workflow génère des suggestions. Mais on peut pousser la logique plus loin en ajoutant des nodes supplémentaires :

| Node | Rôle |

|---|---|

| WordPress (ou API custom) | Récupère le contenu actuel de la page |

| Code (JavaScript) | Insère le lien à l’endroit suggéré |

| WordPress | Met à jour la page avec le nouveau contenu |

Notre conseil : commencez par la version “suggestions seules”. Validez manuellement les premiers résultats avant d’automatiser l’insertion. Un lien mal placé peut faire plus de mal que pas de lien du tout.

Workflow 4 – Auditer la cannibalisation de mots-clés

Le problème qu’on résout

Vous avez 3 articles qui ciblent “chaussures de running”. Résultat : Google ne sait pas lequel positionner. Vos pages se battent entre elles au lieu de se battre contre vos concurrents.

La cannibalisation SEO, c’est quand plusieurs pages de votre site visent la même requête. Au lieu de cumuler leur force, elles se neutralisent. Votre classement stagne, voire régresse.

Identifier ces conflits manuellement ? Il faut croiser vos données Search Console, analyser chaque page, comparer les mots-clés… Comptez une journée pour un site de taille moyenne. Ce workflow réduit ça à quelques minutes.

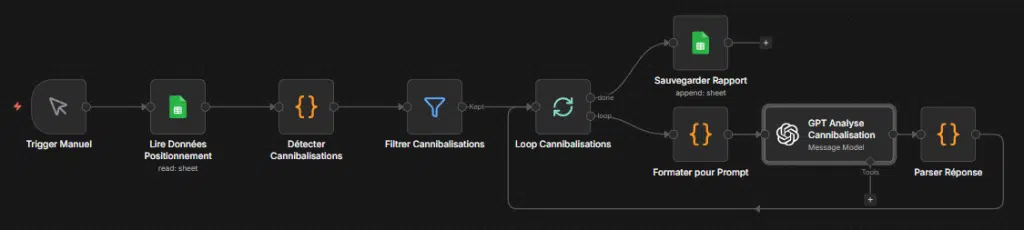

Ce que fait ce workflow

- Il récupère vos données de positionnement (Search Console ou export SEMrush/Ahrefs)

- Il regroupe les URLs qui se positionnent sur les mêmes requêtes

- Il demande à GPT-5.2 d’analyser chaque cas de cannibalisation potentielle

- Il génère un rapport avec des recommandations : fusionner, rediriger, ou différencier

Les nodes utilisés

| Node | Rôle |

|---|---|

| Google Sheets | Import des données de positionnement (requête, URL, position, clics) |

| Code (JavaScript) | Regroupe les URLs par requête pour détecter les doublons |

| OpenAI (GPT-5.2) | Analyse chaque cas et propose une solution |

| Google Sheets | Exporte le rapport d’audit avec les recommandations |

Le prompt ChatGPT qu’on utilise

Tu es un consultant SEO expert en architecture de site e-commerce.

Voici un cas de cannibalisation potentielle :

- Requête : {{requete}}

- Pages en concurrence :

{{liste_pages}}

Pour chaque page, tu as :

- URL

- Titre

- Position moyenne

- Nombre de clics (30 derniers jours)

Analyse ce cas et recommande UNE action parmi :

1. FUSIONNER : combiner les contenus en une seule page (précise laquelle garder)

2. REDIRIGER : supprimer une page et rediriger vers l'autre

3. DIFFÉRENCIER : modifier une page pour cibler une requête différente (suggère laquelle)

4. CONSERVER : la cannibalisation n'est pas problématique (explique pourquoi)

Ta réponse doit inclure :

- L'action recommandée

- La justification (2-3 phrases)

- Les étapes concrètes à suivre

Réponds en JSON.

Comment interpréter les résultats

Le workflow génère un rapport, mais l’expertise humaine reste indispensable pour la décision finale. Voici comment lire les recommandations :

| Recommandation | Quand l’appliquer | Attention |

|---|---|---|

| Fusionner | Deux pages traitent exactement le même sujet | Gardez celle avec le plus de backlinks |

| Rediriger | Une page n’apporte rien de plus que l’autre | Vérifiez qu’aucun trafic ne sera perdu |

| Différencier | Les pages ont un potentiel distinct | Retravaillez les balises title et H1 |

| Conserver | Les pages ciblent des intentions différentes | Surveillez l’évolution dans Search Console |

Notre recommandation : lancez ce workflow une fois par trimestre. La cannibalisation revient naturellement quand on publie régulièrement. Mieux vaut la traiter avant qu’elle n’impacte vos clients et leur expérience de recherche.

Aller plus loin

Pour une analyse plus poussée, vous pouvez :

- Ajouter le volume de recherche via l’API Semrush ou Ahrefs pour prioriser les pages à fort potentiel

- Intégrer les données de clics depuis la Search Console pour identifier les pages qui cannibalisent le trafic réel

- Créer des règles automatiques : si deux pages partagent plus de 5 mots-clés avec un écart de position inférieur à 3, déclencher une alerte

La cannibalisation est un symptôme. La cause est souvent une architecture de contenu floue ou une stratégie de mots-clés mal définie. Ce type d’audit automatisé permet de détecter le problème, mais la solution reste humaine : fusionner, rediriger, ou repositionner.

Et avec l’essor de la recherche vocale et IA, cette question de cannibalisation devient encore plus critique. Les assistants IA ne renvoient qu’une seule réponse, pas dix liens.

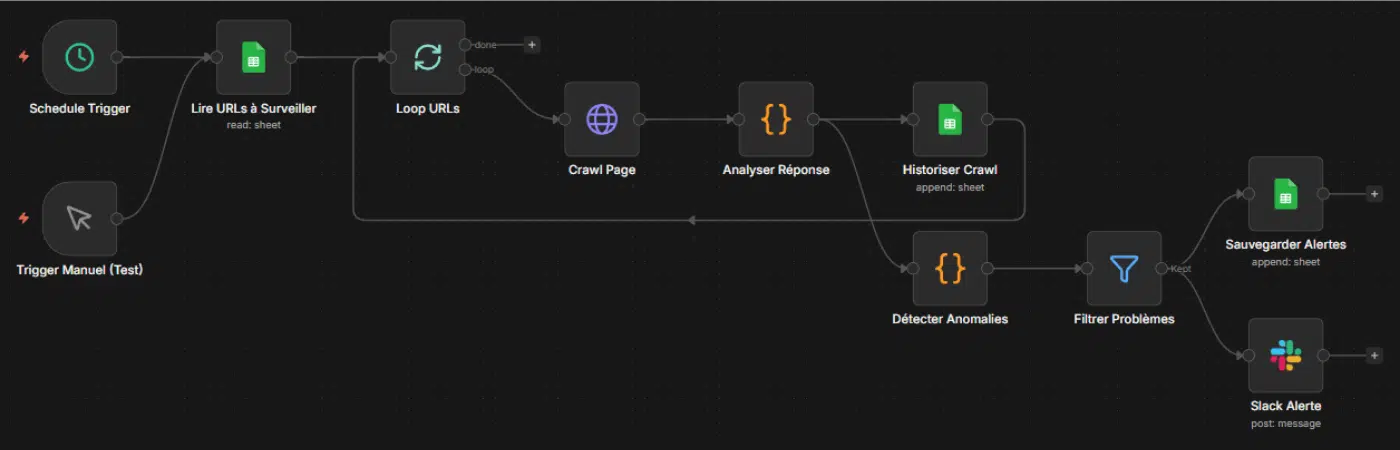

Workflow 5 – Monitorer les erreurs de crawl en temps réel

Le problème qu’on résout

Une page produit renvoie une erreur 404. Une catégorie charge en 8 secondes. Une redirection boucle sur elle-même. Et vous ne le découvrez que 3 semaines plus tard, quand votre trafic a déjà chuté.

Les erreurs techniques tuent le SEO à petit feu. Google crawle votre site, rencontre des problèmes, et finit par moins revenir. Vos pages sortent de l’index sans prévenir.

Vérifier manuellement chaque jour ? Personne ne le fait. Ce workflow surveille votre site en continu et vous alerte uniquement quand il y a un problème.

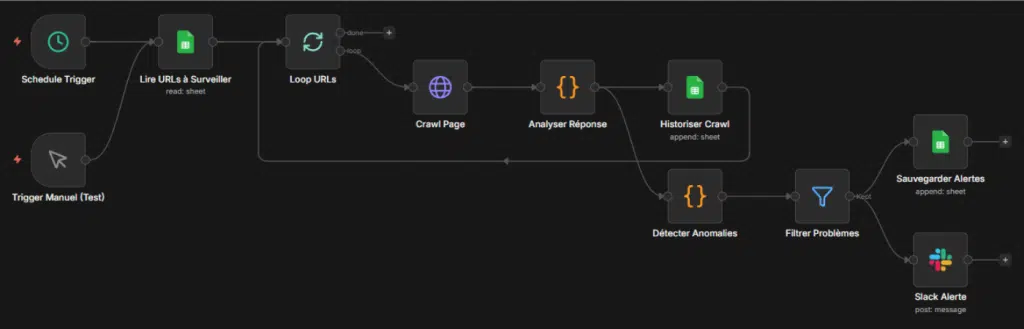

Ce que fait ce workflow

- Il crawle vos pages stratégiques à intervalle régulier (toutes les heures, tous les jours…)

- Il vérifie le code HTTP, le temps de réponse et la présence des balises essentielles

- Il compare avec le crawl précédent pour détecter les changements

- Il vous envoie une alerte Slack ou email uniquement en cas d’anomalie

Les nodes utilisés

| Node | Rôle |

|---|---|

| Schedule Trigger | Déclenche le workflow selon la fréquence choisie |

| Google Sheets | Liste des URLs stratégiques à surveiller |

| HTTP Request | Crawle chaque page et récupère le code de réponse + temps de chargement |

| Code (JavaScript) | Analyse les réponses et détecte les anomalies |

| Google Sheets | Historise les données pour comparaison |

| Slack (ou Email) | Envoie l’alerte si problème détecté |

La logique de détection

Le node Code analyse chaque réponse selon ces critères :

| Vérification | Seuil d’alerte | Pourquoi c’est critique |

|---|---|---|

| Code HTTP | ≠ 200 | Une 404 ou 500 bloque l’indexation |

| Temps de réponse | > 3 secondes | Google pénalise les pages lentes |

| Balise title | Absente ou vide | Page non optimisée pour la recherche |

| Balise canonical | Absente ou incorrecte | Risque de contenu dupliqué |

| Changement vs. crawl précédent | Title ou H1 modifié | Détecte les modifications non intentionnelles |

Le code JavaScript simplifié

const alertes = [];

for (const page of items) {

const problemes = [];

// Vérification code HTTP

if (page.json.statusCode !== 200) {

problemes.push(`Code ${page.json.statusCode}`);

}

// Vérification temps de réponse

if (page.json.responseTime > 3000) {

problemes.push(`Temps: ${page.json.responseTime}ms`);

}

// Si problèmes détectés, ajouter à la liste d'alertes

if (problemes.length > 0) {

alertes.push({

url: page.json.url,

problemes: problemes.join(', '),

date: new Date().toISOString()

});

}

}

return alertes;

Note : ce code est volontairement simplifié. En production, on ajoute la vérification des balises, la comparaison avec l’historique, et la gestion des timeouts.

Le message d’alerte Slack

🚨 Alerte SEO – {{$json.problemes.length}} problème(s) détecté(s)

{{#each alertes}}

❌ {{url}}

→ {{problemes}}

{{/each}}

Rapport complet : [lien vers le Google Sheet]

Quelles pages surveiller en priorité

Inutile de monitorer 10 000 URLs. Concentrez-vous sur les pages qui comptent :

- Homepage – Le point d’entrée principal de votre site

- Pages catégories – Elles distribuent le jus SEO vers les fiches produits

- Top 50 des fiches produits – Celles qui génèrent le plus de trafic ou de CA

- Pages de conversion – Panier, checkout, landing pages campagnes

- Articles de blog stratégiques – Ceux qui rankent et ramènent du trafic

Notre conseil : commencez avec 20-30 URLs maximum. Vous pourrez toujours élargir ensuite. Un workflow qui surveille trop de pages devient lent et coûteux en ressources.

Aller plus loin : ajouter l’intelligence artificielle

Ce workflow basique détecte les problèmes techniques. On peut l’enrichir avec GPT-5.2 pour obtenir un diagnostic plus poussé :

| Ajout | Ce que ça apporte |

|---|---|

| Analyse du contenu | Vérifie que le contenu n’a pas été altéré (piratage, erreur de synchro) |

| Suggestion de correction | Propose une solution adaptée au type d’erreur |

| Priorisation | Classe les alertes par niveau d’urgence selon l’importance de la page |

C’est ce type de solution qu’on déploie chez nos clients e-commerce. Le workflow devient un véritable agent de surveillance qui ne dort jamais.

Quel workflow commencer en premier ?

Cinq workflows, c’est bien. Mais par lequel commencer quand on n’a jamais touché à n8n ?

Voici notre recommandation selon votre situation :

Si vous débutez complètement

Commencez par le workflow 2 (réécriture des fiches produits dupliquées).

Pourquoi ? Parce que c’est le plus simple techniquement. Trois nodes, un prompt, un résultat visible immédiatement. Vous comprenez la logique de n8n sans vous noyer dans la complexité.

Et surtout : le ROI est immédiat. Vous gagnez du temps dès la première fiche réécrite.

Pas encore prêt pour n8n ? Gemini dans Google Sheets offre une alternative encore plus accessible pour générer du contenu SEO en masse, sans aucune installation.

Si vous avez déjà un peu d’expérience

Passez au workflow 1 (génération de meta descriptions) ou au workflow 3 (maillage interne).

Ces workflows introduisent des boucles et des traitements par lots. Vous apprenez à gérer plusieurs éléments en une seule exécution, ce qui est la vraie puissance de l’automatisation.

Si vous êtes à l’aise avec n8n

Attaquez le workflow 4 (audit de cannibalisation) puis le workflow 5 (monitoring des erreurs).

Ces workflows combinent plusieurs sources de données, du code JavaScript, et des logiques conditionnelles. C’est là que n8n révèle tout son potentiel pour le SEO e-commerce.

Le piège à éviter

Ne cherchez pas à tout automatiser d’un coup. On voit régulièrement des e-commerçants qui veulent créer “le workflow ultime” qui fait tout. Résultat : un truc inmaintenable qui plante au premier changement d’API.

Mieux vaut cinq workflows simples qui fonctionnent qu’un workflow complexe qu’on n’ose plus toucher.

Et après ces cinq workflows ?

L’automatisation SEO ne s’arrête pas là. Une fois ces bases maîtrisées, d’autres cas d’usage s’ouvrent :

- Génération automatique de FAQ à partir des questions clients (SAV, avis, chatbot)

- Création de briefs éditoriaux basés sur l’analyse des contenus concurrents

- Alertes de ranking quand une page stratégique perd des positions

- Enrichissement de données produits via scraping et reformulation IA

Ces workflows avancés s’inscrivent dans une évolution du search en 2026 où l’IA prend une place croissante. D’ailleurs, si le sujet vous intéresse, on a écrit un guide complet pour optimiser son SEO pour ChatGPT.

Ces workflows avancés, on les construit sur mesure pour nos clients e-commerce. La logique reste la même : automatiser ce qui peut l’être pour concentrer l’expertise humaine là où elle compte vraiment. C’est d’ailleurs le cœur de notre approche en tant qu’Agence SEO IA : combiner l’automatisation intelligente avec la stratégie humaine.

Charly ROUGET

J’aide les e-commerçants à améliorer leur visibilité grâce à des stratégies SEO durables : audit, contenu et netlinking. Mon objectif est simple : transformer le trafic en résultats concrets pour votre business.